MetroCluster マニュアル ( CA08871-401 )

MetroCluster IP構成の拡張

ONTAPのバージョンに応じた方法で4つの新しいノードを新しいDRグループとして追加することで、MetroCluster IP構成を拡張できます。

ONTAP 9.9.1以降では、MetroCluster IP構成に2つ目のDRグループとして4つの新しいノードを追加することができます。これにより、8ノードMetroCluster構成が作成されます。

-

古いノードと新しいノードで同じバージョンのONTAPが実行されている必要があります。

-

ここでは、既存のMetroCluster IP構成に1つの4ノードDRグループを追加するために必要な手順について説明します。8ノード構成を更新する場合は、DRグループごとに手順全体を繰り返して、1つずつ追加する必要があります。

-

古いプラットフォーム モデルと新しいプラットフォーム モデルのプラットフォームの混在がサポートされていることを確認します。

-

古いプラットフォーム モデルと新しいプラットフォーム モデルの両方がIPスイッチでサポートされていることを確認します。

-

古いノードにデフォルトのブロードキャスト ドメインが作成されていることを確認します。

デフォルトのブロードキャスト ドメインがない既存のクラスタに新しいノードを追加すると、想定される名前ではなくUniversal Unique Identifier(UUID)を使用して新しいノード用のノード管理LIFが作成されます。

この手順で使用する名前

この手順では、次のような名前を使用して、関連するDRグループ、ノード、およびスイッチを示します。

DRグループ |

site_Aのcluster_A |

site_Bのcluster_B |

|---|---|---|

dr_group_1-old |

|

|

dr_group_2-new |

|

|

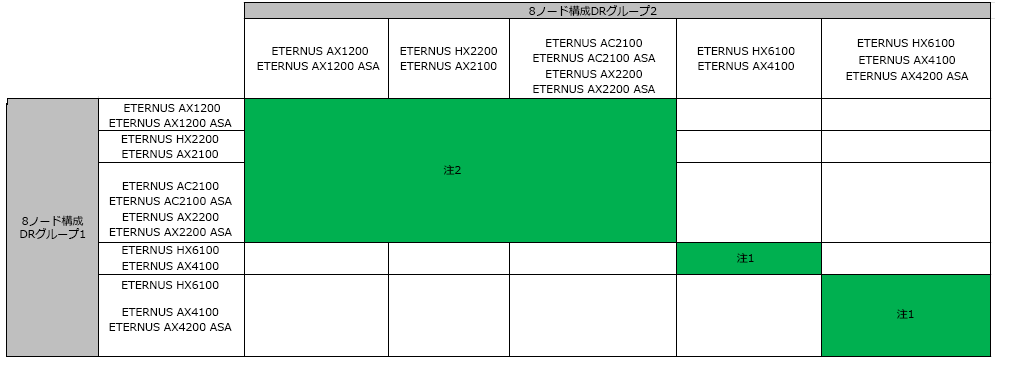

2つ目のDRグループの追加時にサポートされるプラットフォームの組み合わせ

次の表は、8ノードのIP構成でサポートされるプラットフォームの組み合わせを示しています。

|

-

注1:これらの組み合わせには、ONTAP 9.9.1以降(またはプラットフォームでサポートされる最小バージョンのONTAP)が必要です。

-

注2:これらの組み合わせには、ONTAP 9.13.1以降(またはプラットフォームでサポートされる最小バージョンのONTAP)が必要です。

メンテナンス前のカスタムAutoSupportメッセージの送信

メンテナンスを開始する前に、AutoSupportメッセージを発行して、メンテナンスが進行中であることを弊社のサポートに通知する必要があります。システム停止が発生したと判断されないように、メンテナンスが進行中であることを通知する必要があります。

このタスクはMetroClusterサイトごとに実行する必要があります。

-

サポート ケースの自動生成を停止するには、アップグレード中であることを通知するAutoSupportメッセージを送信します。

-

次のコマンドを実行します。

system node autosupport invoke -node * -type all -message "MAINT=10h Upgrading old-model to new-model"この例では、メンテナンス時間を10時間にしています。計画に応じてより長い時間を設定できます。

この時間より早くメンテナンスが完了した場合は、メンテナンス期間が終了したことを通知するAutoSupportメッセージを送信できます。

system node autosupport invoke -node * -type all -message MAINT=end -

パートナー クラスタで同じコマンドを実行します。

-

MetroCluster構成の健全性の確認

移行を実行する前に、MetroCluster構成の健全性と接続を確認する必要があります。

-

ONTAPでのMetroCluster構成の処理を確認します。

-

システムがマルチパスかをチェックします。

node run -node node-name sysconfig -a -

ヘルス アラートが発生していないかを両方のクラスタでチェックします。

system health alert show -

MetroCluster構成と運用モードが正常な状態であることを確認します。

metrocluster show -

MetroClusterチェックを実行します。

metrocluster check run -

MetroClusterチェックの結果を表示します。

metrocluster check show -

Config Advisorを実行します。

-

Config Advisorを実行したあと、ツールの出力を確認し、問題が検出された場合は表示される推奨事項に従って対処します。

-

-

クラスタが正常に動作していることを確認します。

cluster showcluster_A::> cluster show Node Health Eligibility -------------- ------ ----------- node_A_1 true true node_A_2 true true cluster_A::>

-

すべてのクラスタ ポートが動作していることを確認します。

network port show -ipspace Clustercluster_A::> network port show -ipspace Cluster Node: node_A_1-old Speed(Mbps) Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status --------- ------------ ---------------- ---- ---- ----------- -------- e0a Cluster Cluster up 9000 auto/10000 healthy e0b Cluster Cluster up 9000 auto/10000 healthy Node: node_A_2-old Speed(Mbps) Health Port IPspace Broadcast Domain Link MTU Admin/Oper Status --------- ------------ ---------------- ---- ---- ----------- -------- e0a Cluster Cluster up 9000 auto/10000 healthy e0b Cluster Cluster up 9000 auto/10000 healthy 4 entries were displayed. cluster_A::> -

すべてのクラスタ管理LIFが動作していることを確認します。

network interface show -vserver Cluster各クラスタ管理LIFで、Is Homeにはtrue、Status Admin/Operにはup/upと表示されるはずです。

cluster_A::> network interface show -vserver cluster Logical Status Network Current Current Is Vserver Interface Admin/Oper Address/Mask Node Port Home ----------- ---------- ---------- ------------------ ------------- ------- ----- Cluster node_A_1-old_clus1 up/up 169.254.209.69/16 node_A_1 e0a true node_A_1-old_clus2 up/up 169.254.49.125/16 node_A_1 e0b true node_A_2-old_clus1 up/up 169.254.47.194/16 node_A_2 e0a true node_A_2-old_clus2 up/up 169.254.19.183/16 node_A_2 e0b true 4 entries were displayed. cluster_A::> -

すべてのクラスタ管理LIFで自動リバートが有効になっていることを確認します。

network interface show -vserver Cluster -fields auto-revertcluster_A::> network interface show -vserver Cluster -fields auto-revert Logical Vserver Interface Auto-revert --------- ------------- ------------ Cluster node_A_1-old_clus1 true node_A_1-old_clus2 true node_A_2-old_clus1 true node_A_2-old_clus2 true 4 entries were displayed. cluster_A::>

新しいコントローラー モジュールの準備

新しいMetroClusterノードを4つ準備し、正しいバージョンのONTAPをインストールする必要があります。

このタスクは、新しいノードごとに実行する必要があります。

-

node_A_3-new

-

node_A_4-new

-

node_B_3-new

-

node_B_4-new

この手順では、ノードの設定をクリアし、新しいドライブのメールボックス領域を消去します。

-

新しいコントローラーをラックに設置します。

-

「MetroClusterのインストールおよび設定」に従って、新しいMetroCluster IPノードをIPスイッチにケーブル接続します。

-

「MetroClusterのインストールおよび設定」の次のセクションに従って、MetroCluster IPノードを設定します。

-

メンテナンス モードで、

haltコマンドを実行してメンテナンス モードを終了し、boot_ontapコマンドでシステムをブートしてクラスタ セットアップを開始します。クラスタ ウィザードやノード ウィザードはまだ実行しないでください。

RCFファイルのアップグレード

新しいスイッチ ファームウェアをインストールする場合は、スイッチ ファームウェアをインストールしてからRCFファイルをアップグレードする必要があります。

処理を実行中、RCFファイルをアップグレードするスイッチではトラフィックが中断します。トラフィックは新しいRCFファイルを適用すると再開します。

-

構成の健全性を確認します。

-

MetroClusterコンポーネントが健全であることを確認します。

metrocluster check runcluster_A::*> metrocluster check run

この処理はバックグラウンドで実行されます。

-

metrocluster check run処理が完了したら、metrocluster check showを実行して結果を確認します。約5分後に、次の結果が表示されます。

----------- ::*> metrocluster check show Component Result ------------------- --------- nodes ok lifs ok config-replication ok aggregates warning clusters ok connections not-applicable volumes ok 7 entries were displayed.

-

実行中のMetroClusterチェック処理のステータスを確認します。

metrocluster operation history show -job-id 38 -

ヘルス アラートがないことを確認します。

system health alert show

-

-

IPスイッチに新しいRCFファイルを適用できるように準備します。

対応するスイッチ ベンダーの手順に従います。

-

スイッチ ベンダーに対応したIP RCFファイルをダウンロードしてインストールします。

スイッチは次の順序で更新します。 Switch_A_1、Switch_B_1、Switch_A_2、Switch_B_2 -

Cisco IPのRCFファイルのダウンロードとインストール

L2共有ネットワーク構成またはL3ネットワーク構成の場合には、中間スイッチまたはお客様のスイッチのISLポートの調整が必要になることがあります。スイッチ ポート モードが「アクセス」モードから「トランク」モードに変わる可能性があります。2つ目のスイッチ ペア(A_2、B_2)のアップグレードに進むのは、スイッチA_1とB_1との間のネットワーク接続が完全に動作しており、ネットワークが正常な場合だけにしてください。

クラスタへの新しいノードの追加

新しいMetroCluster IPノードを4つ、既存のMetroCluster構成に追加する必要があります。

このタスクは両方のクラスタで実行する必要があります。

-

新しいMetroCluster IPノードを既存のMetroCluster構成に追加します。

-

1つ目の新しいMetroCluster IPノード(node_A_1-new)を既存のMetroCluster IP構成に追加します。

Welcome to the cluster setup wizard. You can enter the following commands at any time: "help" or "?" - if you want to have a question clarified, "back" - if you want to change previously answered questions, and "exit" or "quit" - if you want to quit the cluster setup wizard. Any changes you made before quitting will be saved. You can return to cluster setup at any time by typing "cluster setup". To accept a default or omit a question, do not enter a value. This system will send event messages and periodic reports to Fujitsu Support. To disable this feature, enter autosupport modify -support disable within 24 hours. Enabling AutoSupport can significantly speed problem determination and resolution, should a problem occur on your system. Type yes to confirm and continue {yes}: yes Enter the node management interface port [e0M]: 172.17.8.93 172.17.8.93 is not a valid port. The physical port that is connected to the node management network. Examples of node management ports are "e4a" or "e0M". You can type "back", "exit", or "help" at any question. Enter the node management interface port [e0M]: Enter the node management interface IP address: 172.17.8.93 Enter the node management interface netmask: 255.255.254.0 Enter the node management interface default gateway: 172.17.8.1 A node management interface on port e0M with IP address 172.17.8.93 has been created. Use your web browser to complete cluster setup by accessing https://172.17.8.93 Otherwise, press Enter to complete cluster setup using the command line interface: Do you want to create a new cluster or join an existing cluster? {create, join}: join Existing cluster interface configuration found: Port MTU IP Netmask e0c 9000 169.254.148.217 255.255.0.0 e0d 9000 169.254.144.238 255.255.0.0 Do you want to use this configuration? {yes, no} [yes]: yes . . . -

2つ目の新しいMetroCluster IPノード(node_A_2-new)を既存のMetroCluster IP構成に追加します。

-

-

同じ手順を繰り返して、node_B_1-newとnode_B_2-newをcluster_Bに追加します。

クラスタ間LIFの設定、MetroClusterインターフェイスの作成、ルート アグリゲートのミラーリング

クラスタ ピアリングLIFを作成し、新しいMetroCluster IPノードにMetroClusterインターフェイスを作成する必要があります。

この例で使用しているホーム ポートはプラットフォーム固有です。MetroCluster IPノードのプラットフォームに固有の適切なホーム ポートを使用してください。

-

新しいMetroCluster IPノードで、次の手順に従ってクラスタ間LIFを設定します。

-

各サイトで、クラスタ ピアリングが設定されていることを確認します。

cluster peer show次の例は、cluster_Aのクラスタ ピアリング設定を示しています。

cluster_A:> cluster peer show Peer Cluster Name Cluster Serial Number Availability Authentication ------------------------- --------------------- -------------- -------------- cluster_B 1-80-000011 Available ok

次の例は、cluster_Bのクラスタ ピアリング設定を示しています。

cluster_B:> cluster peer show Peer Cluster Name Cluster Serial Number Availability Authentication ------------------------- --------------------- -------------- -------------- cluster_A 1-80-000011 Available ok cluster_B::>

-

MetroCluster IPノードのDRグループを作成します。

metrocluster configuration-settings dr-group create -partner-clusterMetroCluster構成の設定と接続の詳細については、以下を参照してください。

cluster_A::> metrocluster configuration-settings dr-group create -partner-cluster cluster_B -local-node node_A_1-new -remote-node node_B_1-new [Job 259] Job succeeded: DR Group Create is successful. cluster_A::>

-

DRグループが作成されたことを確認します。

metrocluster configuration-settings dr-group showcluster_A::> metrocluster configuration-settings dr-group show DR Group ID Cluster Node DR Partner Node ----------- -------------------------- ------------------ ------------------ 1 cluster_A node_A_1-old node_B_1-old node_A_2-old node_B_2-old cluster_B node_B_1-old node_A_1-old node_B_2-old node_A_2-old 2 cluster_A node_A_1-new node_B_1-new node_A_2-new node_B_2-new cluster_B node_B_1-new node_A_1-new node_B_2-new node_A_2-new 8 entries were displayed. cluster_A::> -

新しく追加したMetroCluster IPノードのMetroCluster IPインターフェイスを設定します。

metrocluster configuration-settings interface create -cluster-name-

一部のプラットフォームでは、MetroCluster IPインターフェイスにVLANが使用されます。デフォルトでは、2つのポートのそれぞれで異なるVLAN(10と20)が使用されます。

metrocluster configuration-settings interface createコマンドの-vlan-idパラメーターを使用して、デフォルトとは異なる100よりも大きいVLAN(101~4095)を指定することもできます。 -

ONTAP 9.9.1以降では、レイヤー3構成を使用している場合、MetroCluster IPインターフェイスの作成時に

-gatewayパラメーターも指定する必要があります。「レイヤー3ワイドエリア ネットワークに関する考慮事項」を参照してください。

使用されているVLANが10と20、または100よりも大きい場合、次のプラットフォーム モデルを既存のMetroCluster構成に追加できます。他のVLANが使用されている場合は、これらのプラットフォームを既存の構成に追加することはできません。MetroClusterインターフェイスを設定できないためです。 他のプラットフォームを使用している場合、ONTAPでは必要ないため、VLAN構成は問題になりません。

ETERNUS AX series

ETERNUS HX series

-

ETERNUS AX2100

-

ETERNUS AX2200

-

ETERNUS AX4100

-

ETERNUS HX2200

-

ETERNUS HX6100

MetroCluster IPインターフェイスはどちらのクラスタからも設定できます。 cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_1-new -home-port e1a -address 172.17.26.10 -netmask 255.255.255.0 [Job 260] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_1-new -home-port e1b -address 172.17.27.10 -netmask 255.255.255.0 [Job 261] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_2-new -home-port e1a -address 172.17.26.11 -netmask 255.255.255.0 [Job 262] Job succeeded: Interface Create is successful. cluster_A::> :metrocluster configuration-settings interface create -cluster-name cluster_A -home-node node_A_2-new -home-port e1b -address 172.17.27.11 -netmask 255.255.255.0 [Job 263] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_1-new -home-port e1a -address 172.17.26.12 -netmask 255.255.255.0 [Job 264] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_1-new -home-port e1b -address 172.17.27.12 -netmask 255.255.255.0 [Job 265] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_2-new -home-port e1a -address 172.17.26.13 -netmask 255.255.255.0 [Job 266] Job succeeded: Interface Create is successful. cluster_A::> metrocluster configuration-settings interface create -cluster-name cluster_B -home-node node_B_2-new -home-port e1b -address 172.17.27.13 -netmask 255.255.255.0 [Job 267] Job succeeded: Interface Create is successful.

-

-

MetroCluster IPインターフェイスが作成されたことを確認します。

metrocluster configuration-settings interface showcluster_A::>metrocluster configuration-settings interface show DR Config Group Cluster Node Network Address Netmask Gateway State ----- ------- ------- --------------- --------------- --------------- --------- 1 cluster_A node_A_1-old Home Port: e1a 172.17.26.10 255.255.255.0 - completed Home Port: e1b 172.17.27.10 255.255.255.0 - completed node_A_2-old Home Port: e1a 172.17.26.11 255.255.255.0 - completed Home Port: e1b 172.17.27.11 255.255.255.0 - completed cluster_B node_B_1-old Home Port: e1a 172.17.26.13 255.255.255.0 - completed Home Port: e1b 172.17.27.13 255.255.255.0 - completed node_B_1-old Home Port: e1a 172.17.26.12 255.255.255.0 - completed Home Port: e1b 172.17.27.12 255.255.255.0 - completed 2 cluster_A node_A_3-new Home Port: e1a 172.17.28.10 255.255.255.0 - completed Home Port: e1b 172.17.29.10 255.255.255.0 - completed node_A_3-new Home Port: e1a 172.17.28.11 255.255.255.0 - completed Home Port: e1b 172.17.29.11 255.255.255.0 - completed cluster_B node_B_3-new Home Port: e1a 172.17.28.13 255.255.255.0 - completed Home Port: e1b 172.17.29.13 255.255.255.0 - completed node_B_3-new Home Port: e1a 172.17.28.12 255.255.255.0 - completed Home Port: e1b 172.17.29.12 255.255.255.0 - completed 8 entries were displayed. cluster_A> -

MetroCluster IPインターフェイスを接続します。

metrocluster configuration-settings connection connectこのコマンドは、完了するまでに数分かかることがあります。 cluster_A::> metrocluster configuration-settings connection connect cluster_A::>

-

接続が正しく確立されたことを確認します。

metrocluster configuration-settings connection showcluster_A::> metrocluster configuration-settings connection show DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 1 cluster_A node_A_1-old Home Port: e1a 172.17.28.10 172.17.28.11 HA Partner completed Home Port: e1a 172.17.28.10 172.17.28.12 DR Partner completed Home Port: e1a 172.17.28.10 172.17.28.13 DR Auxiliary completed Home Port: e1b 172.17.29.10 172.17.29.11 HA Partner completed Home Port: e1b 172.17.29.10 172.17.29.12 DR Partner completed Home Port: e1b 172.17.29.10 172.17.29.13 DR Auxiliary completed node_A_2-old Home Port: e1a 172.17.28.11 172.17.28.10 HA Partner completed Home Port: e1a 172.17.28.11 172.17.28.13 DR Partner completed Home Port: e1a 172.17.28.11 172.17.28.12 DR Auxiliary completed Home Port: e1b 172.17.29.11 172.17.29.10 HA Partner completed Home Port: e1b 172.17.29.11 172.17.29.13 DR Partner completed Home Port: e1b 172.17.29.11 172.17.29.12 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 1 cluster_B node_B_2-old Home Port: e1a 172.17.28.13 172.17.28.12 HA Partner completed Home Port: e1a 172.17.28.13 172.17.28.11 DR Partner completed Home Port: e1a 172.17.28.13 172.17.28.10 DR Auxiliary completed Home Port: e1b 172.17.29.13 172.17.29.12 HA Partner completed Home Port: e1b 172.17.29.13 172.17.29.11 DR Partner completed Home Port: e1b 172.17.29.13 172.17.29.10 DR Auxiliary completed node_B_1-old Home Port: e1a 172.17.28.12 172.17.28.13 HA Partner completed Home Port: e1a 172.17.28.12 172.17.28.10 DR Partner completed Home Port: e1a 172.17.28.12 172.17.28.11 DR Auxiliary completed Home Port: e1b 172.17.29.12 172.17.29.13 HA Partner completed Home Port: e1b 172.17.29.12 172.17.29.10 DR Partner completed Home Port: e1b 172.17.29.12 172.17.29.11 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 2 cluster_A node_A_1-new** Home Port: e1a 172.17.26.10 172.17.26.11 HA Partner completed Home Port: e1a 172.17.26.10 172.17.26.12 DR Partner completed Home Port: e1a 172.17.26.10 172.17.26.13 DR Auxiliary completed Home Port: e1b 172.17.27.10 172.17.27.11 HA Partner completed Home Port: e1b 172.17.27.10 172.17.27.12 DR Partner completed Home Port: e1b 172.17.27.10 172.17.27.13 DR Auxiliary completed node_A_2-new Home Port: e1a 172.17.26.11 172.17.26.10 HA Partner completed Home Port: e1a 172.17.26.11 172.17.26.13 DR Partner completed Home Port: e1a 172.17.26.11 172.17.26.12 DR Auxiliary completed Home Port: e1b 172.17.27.11 172.17.27.10 HA Partner completed Home Port: e1b 172.17.27.11 172.17.27.13 DR Partner completed Home Port: e1b 172.17.27.11 172.17.27.12 DR Auxiliary completed DR Source Destination Group Cluster Node Network Address Network Address Partner Type Config State ----- ------- ------- --------------- --------------- ------------ ------------ 2 cluster_B node_B_2-new Home Port: e1a 172.17.26.13 172.17.26.12 HA Partner completed Home Port: e1a 172.17.26.13 172.17.26.11 DR Partner completed Home Port: e1a 172.17.26.13 172.17.26.10 DR Auxiliary completed Home Port: e1b 172.17.27.13 172.17.27.12 HA Partner completed Home Port: e1b 172.17.27.13 172.17.27.11 DR Partner completed Home Port: e1b 172.17.27.13 172.17.27.10 DR Auxiliary completed node_B_1-new Home Port: e1a 172.17.26.12 172.17.26.13 HA Partner completed Home Port: e1a 172.17.26.12 172.17.26.10 DR Partner completed Home Port: e1a 172.17.26.12 172.17.26.11 DR Auxiliary completed Home Port: e1b 172.17.27.12 172.17.27.13 HA Partner completed Home Port: e1b 172.17.27.12 172.17.27.10 DR Partner completed Home Port: e1b 172.17.27.12 172.17.27.11 DR Auxiliary completed 48 entries were displayed. cluster_A::> -

ディスクの自動割り当てとパーティショニングを確認します。

disk show -pool Pool1cluster_A::> disk show -pool Pool1 Usable Disk Container Container Disk Size Shelf Bay Type Type Name Owner ---------------- ---------- ----- --- ------- ----------- --------- -------- 1.10.4 - 10 4 SAS remote - node_B_2 1.10.13 - 10 13 SAS remote - node_B_2 1.10.14 - 10 14 SAS remote - node_B_1 1.10.15 - 10 15 SAS remote - node_B_1 1.10.16 - 10 16 SAS remote - node_B_1 1.10.18 - 10 18 SAS remote - node_B_2 ... 2.20.0 546.9GB 20 0 SAS aggregate aggr0_rha1_a1 node_a_1 2.20.3 546.9GB 20 3 SAS aggregate aggr0_rha1_a2 node_a_2 2.20.5 546.9GB 20 5 SAS aggregate rha1_a1_aggr1 node_a_1 2.20.6 546.9GB 20 6 SAS aggregate rha1_a1_aggr1 node_a_1 2.20.7 546.9GB 20 7 SAS aggregate rha1_a2_aggr1 node_a_2 2.20.10 546.9GB 20 10 SAS aggregate rha1_a1_aggr1 node_a_1 ... 43 entries were displayed. cluster_A::> -

ルート アグリゲートをミラーします。

storage aggregate mirror -aggregate aggr0_node_A_1-newこの手順はそれぞれのMetroCluster IPノードで実行する必要があります。 cluster_A::> aggr mirror -aggregate aggr0_node_A_1-new Info: Disks would be added to aggregate "aggr0_node_A_1-new"on node "node_A_1-new" in the following manner: Second Plex RAID Group rg0, 3 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 4.20.0 SAS - - parity 4.20.3 SAS - - data 4.20.1 SAS 546.9GB 558.9GB Aggregate capacity available forvolume use would be 467.6GB. Do you want to continue? {y|n}: y cluster_A::> -

ルート アグリゲートがミラーされたことを確認します。

storage aggregate showcluster_A::> aggr show Aggregate Size Available Used% State #Vols Nodes RAID Status --------- -------- --------- ----- ------- ------ ---------------- ------------ aggr0_node_A_1-old 349.0GB 16.84GB 95% online 1 node_A_1-old raid_dp, mirrored, normal aggr0_node_A_2-old 349.0GB 16.84GB 95% online 1 node_A_2-old raid_dp, mirrored, normal aggr0_node_A_1-new 467.6GB 22.63GB 95% online 1 node_A_1-new raid_dp, mirrored, normal aggr0_node_A_2-new 467.6GB 22.62GB 95% online 1 node_A_2-new raid_dp, mirrored, normal aggr_data_a1 1.02TB 1.01TB 1% online 1 node_A_1-old raid_dp, mirrored, normal aggr_data_a2 1.02TB 1.01TB 1% online 1 node_A_2-old raid_dp, mirrored,

新しいノードの追加完了

新しいDRグループをMetroCluster構成に組み込み、新しいノードにミラーされたデータ アグリゲートを作成する必要があります。

-

MetroCluster構成を更新します。

-

advanced権限モードに切り替えます。

set -privilege advanced -

新しいノードの1つでMetroCluster構成を更新します。

metrocluster configure次の例では、両方のDRグループでMetroCluster構成を更新しています。

cluster_A::*> metrocluster configure -refresh true [Job 726] Job succeeded: Configure is successful.

-

新しい各ノードをリブートします。

node reboot -node <node_name> -inhibit-takeover true -

admin権限モードに戻ります。

set -privilege admin

-

-

新しいMetroClusterノードのそれぞれにミラーされたデータ アグリゲートを作成します。

storage aggregate create -aggregate aggregate-name -node node-name -diskcount no-of-disks -mirror true各サイトに少なくとも1つはミラーされたデータ アグリゲートを作成する必要があります。各サイトのMetroCluster IPノードにミラーされたデータ アグリゲートを2つ作成してMDVボリュームをホストすることを推奨しますが、サイトごとにアグリゲートが1つの構成もサポートされます(非推奨)。ミラーされたデータ アグリゲートがMetroClusterの一方のサイトには1つ、もう一方のサイトには複数ある構成もサポートされます。 次の例は、node_A_1-newに新しいアグリゲートを作成します。

cluster_A::> storage aggregate create -aggregate data_a3 -node node_A_1-new -diskcount 10 -mirror t Info: The layout for aggregate "data_a3" on node "node_A_1-new" would be: First Plex RAID Group rg0, 5 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 5.10.15 SAS - - parity 5.10.16 SAS - - data 5.10.17 SAS 546.9GB 547.1GB data 5.10.18 SAS 546.9GB 558.9GB data 5.10.19 SAS 546.9GB 558.9GB Second Plex RAID Group rg0, 5 disks (block checksum, raid_dp) Usable Physical Position Disk Type Size Size ---------- ------------------------- ---------- -------- -------- dparity 4.20.17 SAS - - parity 4.20.14 SAS - - data 4.20.18 SAS 546.9GB 547.1GB data 4.20.19 SAS 546.9GB 547.1GB data 4.20.16 SAS 546.9GB 547.1GB Aggregate capacity available for volume use would be 1.37TB. Do you want to continue? {y|n}: y [Job 440] Job succeeded: DONE cluster_A::> -

ノードが対応するDRグループに追加されたことを確認します。

cluster_A::*> metrocluster node show DR Configuration DR Group Cluster Node State Mirroring Mode ----- ------- ------------------ -------------- --------- -------------------- 1 cluster_A node_A_1-old configured enabled normal node_A_2-old configured enabled normal cluster_B node_B_1-old configured enabled normal node_B_2-old configured enabled normal 2 cluster_A node_A_3-new configured enabled normal node_A_4-new configured enabled normal cluster_B node_B_3-new configured enabled normal node_B_4-new configured enabled normal 8 entries were displayed. cluster_A::*> -

advanced権限で、MDV_CRSボリュームを古いノードから新しいノードに移動します。

-

ボリュームを表示してMDVボリュームを特定します。

サイトにミラーされたデータ アグリゲートが1つしかない場合は、そのアグリゲートに両方のMDVボリュームを移動します。ミラーされたデータ アグリゲートが複数ある場合は、各MDVボリュームを別々のアグリゲートに移動します。 次の例では、

volume showの出力にMDVボリュームが表示されています。cluster_A::> volume show Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- ... cluster_A MDV_CRS_2c78e009ff5611e9b0f300a0985ef8c4_A aggr_b1 - RW - - - cluster_A MDV_CRS_2c78e009ff5611e9b0f300a0985ef8c4_B aggr_b2 - RW - - - cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_A aggr_a1 online RW 10GB 9.50GB 0% cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_B aggr_a2 online RW 10GB 9.50GB 0% ... 11 entries were displayed.mple -

権限レベルをadvancedに設定します。

set -privilege advanced -

MDVボリュームを1つずつ移動します。

volume move start -volume mdv-volume -destination-aggregate aggr-on-new-node -vserver vserver-name次の例は、「MDV_CRS_d6b0b313ff5611e9837100a098544e51_A」を「node_A_3」のアグリゲート「data_a3」に移動するコマンドと出力を示しています。

cluster_A::*> vol move start -volume MDV_CRS_d6b0b313ff5611e9837100a098544e51_A -destination-aggregate data_a3 -vserver cluster_A Warning: You are about to modify the system volume "MDV_CRS_d6b0b313ff5611e9837100a098544e51_A". This might cause severe performance or stability problems. Do not proceed unless directed to do so by support. Do you want to proceed? {y|n}: y [Job 494] Job is queued: Move "MDV_CRS_d6b0b313ff5611e9837100a098544e51_A" in Vserver "cluster_A" to aggregate "data_a3". Use the "volume move show -vserver cluster_A -volume MDV_CRS_d6b0b313ff5611e9837100a098544e51_A" command to view the status of this operation. -

volume showコマンドを使用して、MDVボリュームが正常に移動されたことを確認します。volume show mdv-name次の出力は、MDVボリュームが正常に移動されたことを示しています。

cluster_A::*> vol show MDV_CRS_d6b0b313ff5611e9837100a098544e51_B Vserver Volume Aggregate State Type Size Available Used% --------- ------------ ------------ ---------- ---- ---------- ---------- ----- cluster_A MDV_CRS_d6b0b313ff5611e9837100a098544e51_B aggr_a2 online RW 10GB 9.50GB 0%

-

-

古いノードから新しいノードにイプシロンを移動します。

-

現在イプシロンが設定されているノードを特定します。

cluster show -fields epsiloncluster_B::*> cluster show -fields epsilon node epsilon ---------------- ------- node_A_1-old true node_A_2-old false node_A_3-new false node_A_4-new false 4 entries were displayed.

-

古いノード(node_A_1-old)でイプシロンをfalseに設定します。

cluster modify -node old-node -epsilon false* -

新しいノード(node_A_3-new)でイプシロンをtrueに設定します。

cluster modify -node new-node -epsilon true -

イプシロンが正しいノードに移動されたことを確認します。

cluster show -fields epsiloncluster_A::*> cluster show -fields epsilon node epsilon ---------------- ------- node_A_1-old false node_A_2-old false node_A_3-new true node_A_4-new false 4 entries were displayed.

-

-

システムでエンドツーエンドの暗号化がサポートされている場合は、新しいDRグループでエンドツーエンドの暗号化を有効にすることができます。